|

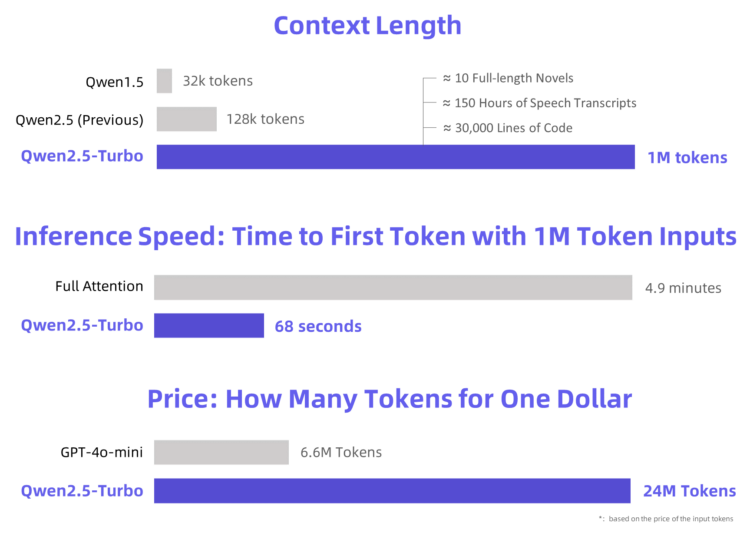

阿里云于2024年11月19日正式发布了Qwen2.5-Turbo开源AI模型。这款新模型旨在满足社区对更长上下文长度的需求,将处理上下文长度扩展至100万个tokens,相当于约100万英文单词或150万中文字符,能够处理大量文本,如10部完整小说、150小时演讲稿或30000行代码。

Qwen2.5-Turbo通过采用稀疏注意力机制,显著提升了处理速度,将处理100万tokens至输出首个token的时间从4.9分钟缩短至68秒,提升了4.3倍的速度。在1M-token的Passkey检索任务中,该模型达到了100%的准确率,并在RULER长文本评估中得分高达93.1,超越了GPT-4和GLM4-9B-1M等竞争对手。 此外,Qwen2.5-Turbo的处理成本为每百万tokens 0.3元,尽管比GPT-4o-mini高出3.6倍,但其经济性和效率优势使其成为处理长文本的理想选择。然而,开发团队也认识到在实际应用中,长序列任务的表现可能存在不稳定性,且大型模型的推理成本仍有待优化。因此,团队承诺将持续优化模型的人类偏好度、提升推理效率,并探索更先进的长上下文处理技术。 阿里云此次发布的Qwen2.5-Turbo不仅在技术上取得了重大突破,还展示了其在经济性和效率方面的显著优势,为开发者和企业提供了强大的支持,推动了AI技术在更多领域的应用。 |