|

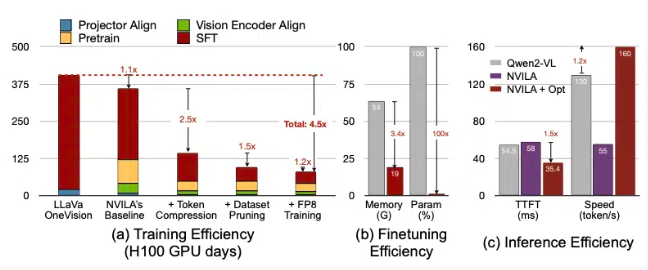

英伟达最近发布了一款名为NVILA的全新视觉语言模型。这款模型通过优化预训练方法,实现了多图像推理和增强型上下文学习的能力,并在多个基准测试中超越了现有的SOTA模型LLaVA-1.5。

NVILA的核心创新在于其独特的交错图像-文本预训练方法,这种方法不同于传统的单一图像-文本对预训练,而是采用交错的图像-文本数据进行训练,这对于视频理解和多图像理解至关重要。此外,NVILA还采用了动态注意力机制,允许模型根据任务需求调整对视觉和文本输入的关注程度,这使得它在处理复杂的视觉语言交互时表现尤为出色。 NVILA模型架构包括视觉编码器、语言处理单元和融合层,这些组件共同工作以生成统一的多模态表从示,而支持跨模态任务。在实际应用中,NVILA能够处理并理解多个图像之间的关系,执行复杂的图像间推理任务,并在视觉问答、图像描述生成等任务中展现出色的性能。 NVILA不仅在视觉语言任务上表现出色,还在纯文本任务中保持了高效的性能。这得益于其在训练过程中结合了高质量的文本数据集,并采用了创新的架构设计。这种设计使得NVILA能够在不损失性能的前提下,成功平衡文本和图像处理的复杂性。 NVILA的发布标志着英伟达在视觉语言模型领域的重大进展,为多模态人工智能应用带来了更多可能性。这一模型不仅为学术研究提供了新方向,也为诸如自动驾驶、智能家居等领域的应用奠定了坚实的基础。 |