|

中国科研团队近日重磅发布了一款名为VideoChat-Flash的创新视频建模系统,该系统在长视频处理和高效建模领域取得了突破性进展。这一成果由中国科研团队于2024年3月24日通过开源项目“OpenGVLab/VideoChat”正式对外公布。

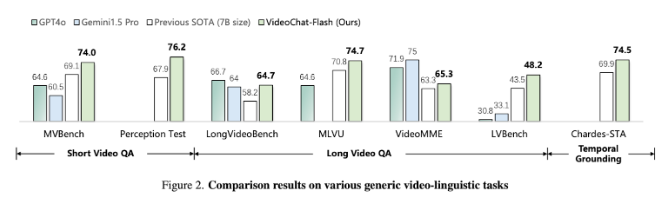

核心技术与特点 VideoChat-Flash采用了先进的“层次压缩”方法,能够实现超长视频的快速处理和高精度评估。其核心优势包括: 超长视频支持:该模型能够处理长达三小时的视频,并在10,000帧视频上的评估中达到了“针入沙中”的精度,准确率高达99.1%。 高效推理速度:每秒可处理16个视频帧,推理速度比前一代模型快5到10倍。 轻量化设计:每个视频帧仅需编码为16个令牌(tokens),显著降低了计算资源消耗。 为了进一步提升模型性能,研究团队还优化了评估工具,并构建了包含200万样本的多源指令数据集MH-NIHA,为模型训练提供了更丰富的数据支持。 应用场景与未来展望 VideoChat-Flash不仅在学术研究中具有重要意义,还将在实际应用中发挥重要作用。例如: 视频内容分析:通过高效建模技术,可以快速提取视频中的关键信息,用于事件定位、因果关系推断等场景。 长视频实时交互:结合其他技术,如清华大学与字节跳动联合开发的Flash-VStream模型,可进一步提升在线视频流的理解能力,实现流畅的实时交互体验。 多模态学习:未来,该模型有望与其他视觉语言模型(如VideoChat)结合,推动时空推理和因果关系推断技术的发展。 重要里程碑 此次发布的VideoChat-Flash是该系列模型的第二代产品。此前,2024年12月29日,研究团队已发布了VideoChat-Flash2和MH-NIHA,并对评估工具进行了优化。这些成果表明,中国科研团队在视频建模领域持续保持领先地位。 总结 VideoChat-Flash的发布标志着中国科研团队在视频建模技术上的又一次重大突破。其高效、精准和轻量化的特性将为学术研究和实际应用提供强有力的支持。随着更多相关技术的融合与发展,相信这一系统将在未来进一步推动人工智能领域的创新与进步。 |