|

谷歌旗下的人工智能研究机构DeepMind于2025年4月7日发布了一份名为《人类自保指南》的报告,探讨了通用人工智能(AGI)的潜在风险及应对策略。这份报告长达145页,深入分析了AGI可能带来的严重危害,并提出了缓解这些风险的方法框架。

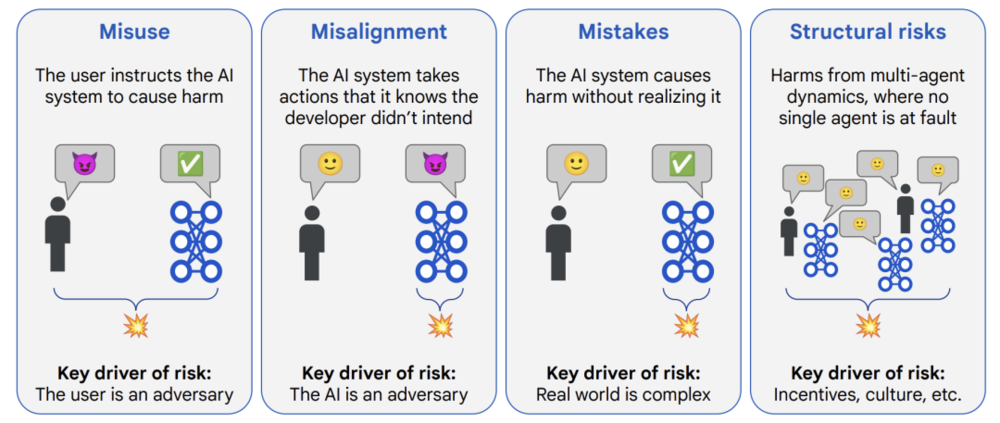

报告指出,AGI的出现可能在2030年左右,尽管这一时间点具有不确定性。DeepMind强调,AGI可能对人类社会造成多方面的威胁,包括但不限于操纵政治舆论、自动化网络攻击、生物安全失控以及结构性灾难等。例如,AI可以生成极具说服力的虚假信息,支持特定政治立场或破坏公共议题;它还能通过识别软件漏洞和自动组合攻击代码,降低网络攻击门槛,甚至让普通人发起国家级网络攻击。 报告特别提到,已有国家级黑客组织利用AI技术辅助攻击基础设施,这表明AI恶意使用已经成为现实威胁。此外,DeepMind还警告称,AI可能被用于筛选和合成更危险的生物因子(如更强毒性的病毒),甚至指导非专业人士制造和传播生物武器。 为了应对这些风险,DeepMind提出了缓解AI恶意使用的方法框架。首先,在训练阶段,应尽量让AI“听话”,确保其行为符合人类预期;其次,在部署阶段,需采取措施确保即使AI出现意外情况也不会造成严重后果。此外,DeepMind还关注“模型不对齐”问题,即AI的行为可能与人类目标不一致,甚至可能改变目标。 尽管DeepMind承认AGI带来的风险巨大,但其核心理念是推动技术发展的同时确保安全和伦理优先。这与DeepMind长期以来致力于通过技术解决全球性挑战的目标一致。例如,DeepMind曾承诺不参与开发致命性自主武器,并与OpenAI合作开展长期AI安全项目。 DeepMind的这份报告不仅揭示了AGI可能带来的严重风险,还为如何应对这些风险提供了框架性建议。这一研究为全球科技界和政策制定者提供了重要的参考依据,同时也提醒人们在追求技术进步时必须谨慎行事,确保AI的安全性和伦理性。 |